많은 데이터를 빨리 전송할 수 있다는 것은 결국 더 많은 연산을 통해 더 좋은 결과를 빨리 만들어낼 수 있다는 말과 같다. 그 때문에 영화 제작 현장에서는 시간이 곧 제작비로 직결되는 시각특수효과(VFX) 분야에서 누구보다도 먼저 5G 시대를 기대하고 있을 것이다. 화려한 CG로 뒤덮인 블록버스터영화를 만든다고 가정했을 때 중요하게 활용될 다음의 몇 가지 기술은 우리를 어디에서도 본 적 없는 새로운 비주얼 세계로 안내할 것이다.

실시간 렌더링

컴퓨터가 데이터를 이미지로 만들어내는 과정을 렌더링이라고 하는데 기술이 발전할수록 이미지를 만들어내는 데이터의 양은 기하급수적으로 늘어난다. 웬만한 할리우드 애니메이션영화는 100테라바이트를 넘는 경우도 있다니 그 양을 짐작할 수도 없다. 기본적으로 2D영화는 비실시간 렌더링, 즉 사전에 정해진 규칙을 지켜 렌더링한 이미지를 나열하는 방식으로 만든다. 캐릭터의 움직임, 빛의 방향, 카메라 위치가 정해진 대로 렌더링된다. 또 고품질 이미지를 만들어내려면 비싼 연산과 많은 렌더링 시간이 필요하다. 반면 실시간 렌더링은 관객 혹은 사용자의 반응에 따라 모든 이미지를 다르게 보여주는 렌더링이다. 미리 렌더링을 할 수 없고 매우 빠르게 즉각적으로 렌더링돼야 한다. 당연히 게임을 만들 때 흔히 쓰는 기술이다. 그런데 실시간 렌더링은 일반적인 2D영화에서는 구현할 수 없는 가상현실(VR) 콘텐츠를 창조하는 데 필수적이다. VR영화 혹은 AR 체험형 콘텐츠 등을 만드는 데 유용하다. 실시간 렌더링을 도입해 영화를 만든다면 단순히 2D영화의 영역을 확장하는 이미지 생산을 넘어 제작 과정에서도 실시간으로 CG 작업을 할 수 있다는 이점도 생긴다. 최근 할리우드의 <레디 플레이어 원> 촬영 방식은 아주 독특했다. 이곳에서는 세트장에서 배우들이 모션캡처를 이용해 촬영하고 그 정보를 전부 컴퓨터로 옮긴 다음 스티븐 스필버그 감독이 기다리고 있는 ‘V캠 텐트’란 곳으로 보낸다. 그러면 스티븐 스필버그 감독이 패드가 달린 작은 디스플레이를 들고 VR 속 세트장을 들여다본다. 영화 속 ‘오아시스’라는 VR 공간과 똑같은 공간을 디자인한 다음 감독이 VR 헤드셋을 끼고 그 안으로 들어가 VR 내에서 촬영하고 그렇게 촬영한 데이터가 즉시 프린트된다. 스필버그 감독이 공간의 디자인 변경을 요구하면 옆에 대기하고 있는 제작진이 그 자리에서 실시간으로 수정한다. 세트장에서 모션캡처를 하는 배우들은 자신들이 아바타를 연기할 때 모니터를 통해 아바타의 모습 그대로 자신들의 모션캡처 연기가 VR 공간에 어떻게 반영되는지를 실시간으로 확인할 수 있다. 다소 복잡하게 소개했는데 시간이 오래 걸리는 렌더링 작업, 대용량 데이터를 주고받아야 하는 작업이 빠르게 단축될 수 있다는 것이 핵심이다. 할리우드에서는 <레디 플레이어 원>뿐만 아니라 <정글북> <로그 원: 스타워즈 스토리> <블레이드 러너 2049>, 최근의 <라이온 킹> 같은 영화현장에서 실시간 CG 구현으로 제작환경을 편리하게 만들었다. 존 파브로 감독이 연출하는 <라이온 킹> 제작현장의 경우에는 감독 혼자 VR 헤드셋을 쓰고 촬영 지시를 내리는 상황을 넘어 여러 명의 헤드 스탭이 VR 세트에 동시에 들어가 작업하는 진풍경이 벌어지기도 했다고. 물론 VR 세트에서는 조명이 해결될 리 없으므로 어려운 작업일 터다. 존 파브로 감독의 <스타워즈> 스핀오프 드라마 <만달로리안>도 이같은 방식을 적극 도입해 만들고 있다는데 그는 이에 대해, “현재 게임 및 드라이브용, VR용으로 제작된 게임 엔진이 실제로 빛을 움직일 때 볼 수 있는 아날로그 미학을 충분히 모방할 수 있는 수준이다”라고 언급하기도 했다.

게임 엔진

실시간 렌더링이란 결국 게임을 만들 수 있는 솔루션으로, 게임에 필요한 실시간 렌더링 기반 기술이 게임을 넘어 영화로 확장 적용된 사례라고 정리할 수 있을 것이다. 게임 엔진에는 유니티 엔진과 언리얼 엔진 두 종류의 소프트웨어가 있다. 유니티 엔진의 프로그래밍 없이 신을 조정하는 ‘타임라인’(Timeline), 스마트 카메라로 다양한 장면을 쉽게 만들 수 있는 ‘시네머신’(Cinemachine), 고사양 그래픽을 렌더링하는 ‘HDRP’(High-Definition Render Pipeline: 고해상도 렌더 파이프라인), 빛의 범위와 강도에 따른 디테일한 조명 효과가 가능한 ‘프로그레시브 라이트매퍼’(Progressive Lightmapper) 등의 기능을 도입해 만든 <블레이드 러너 2049>는 제90회 아카데미 시상식에서 시각효과상을 수상했다. 이 영화는 유니티의 버추얼 프로덕션 기법을 활용해 사전 시각화, 연출, 촬영, 반복 테스트 및 후반작업을 하나의 작업 공간에서 완료해 제작 비용과 기간을 최소화했다. 언리얼 엔진에서는 엔캠(Ncam)이라는 버추얼 세트 및 실시간 그래픽을 구현할 수 있는 맞춤형 플랫폼을 제공하는데, 카메라 하드웨어 애드온과 복잡한 소프트웨어로 가상 및 증강 그래픽 기술을 제공하는 엔캠만의 카메라 추적 솔루션이 있다. 이 시스템은 카메라에 부착된 경량의 센서 바를 이용해 주변 환경의 자연 특징을 추적하기 때문에 카메라가 모든 장소에서 자유롭게 움직이며 정확한 위치, 회전, 렌즈 정보를 끊임없이 생성한다. 이 시스템은 실내, 실외, 와이어 촬영 및 휴대용 카메라에 이르기까지 모든 촬영 방식을 지원하는데, 최근 <데드풀2> <한 솔로: 스타워즈 스토리> <아쿠아맨> 같은 영화에 쓰였다. 일반적인 2D영화는 아니지만 게임 엔진을 활용해 여느 영화 이상의 영상을 기대할 수 있다. 올해 5월과 8월 미국 디즈니랜드에 개장할 예정인 <스타워즈> 테마파크 ‘갤럭시즈 엣지’의 밀레니엄 팔콘 라이드 어트랙션 ‘스머글러즈 런’에는 탑승자가 조종하는 경우의 수에 따라 다른 우주 배경 영상을 보여준다고 한다. 이 영상을 만들어낸 곳이 바로 루카스 필름의 이머시브 엔터테인먼트 그룹인 ILMxLAB과 협업한 언리얼 엔진의 에픽게임즈다. 이 영상은 쿼드로 SLI 프레임 렌더링을 통해 연결된 8개의 고급 NVIDIA 쿼드로 P6000 GPU 그래픽카드와 5대의 쿼드로 싱크 프로젝터를 가동해 초고해상도의 디스플레이를 구현할 것이라고 한다.

홀로그램

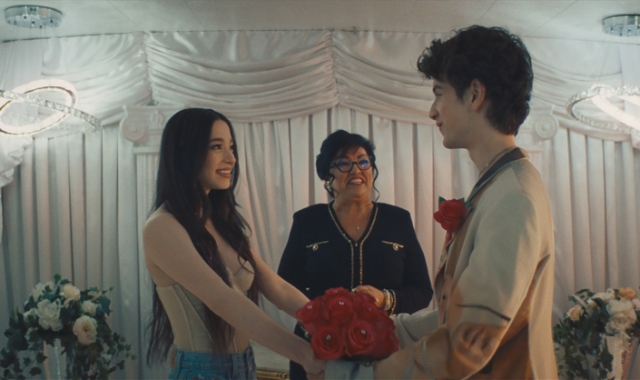

LG유플러스가 자사의 5G 광고를 하면서 내세운 ‘증강현실(AR) 나만의 입체 스타’ 광고는 AR 기술의 일환으로 3D로 촬영한 소스를 개인의 스마트폰에 전송해 카메라로 촬영할 수 있게 만드는 기술이다. 아직 고해상도 그래픽 이미지를 구현하기에는 기술적 한계가 있지만, 앞으로 원격으로 이미지를 클라우드에서 연산시켜 5G 기술로 스마트폰에 전송하는 기술이 발달하면 홀로그램 혹은 홀로그래피 기술이 현실화할 날도 머지않았다. 이 기술이 상용화될 분야도 쇼핑, 의료 등 무궁무진하다. 현재 이와 유사한 맥락의 기술이 볼류메트릭 비디오라는 기술인데 실사로 360도 뎁스를 모두 카메라로 스캔하는 작업이다. 이 기술을 처리하고 스트리밍하는 데는 현재로서 엄청난 통신 대역폭이 필요하다. 그래서 5G 시대가 도래하면 볼류메트릭 비디오 기술이 무엇을 어떻게 바꿔 나갈지 기대할 수밖에 없다.